|

Купить решения «Лаборатории Касперского»

в интернет-магазине Kaspersky-Security.ru |

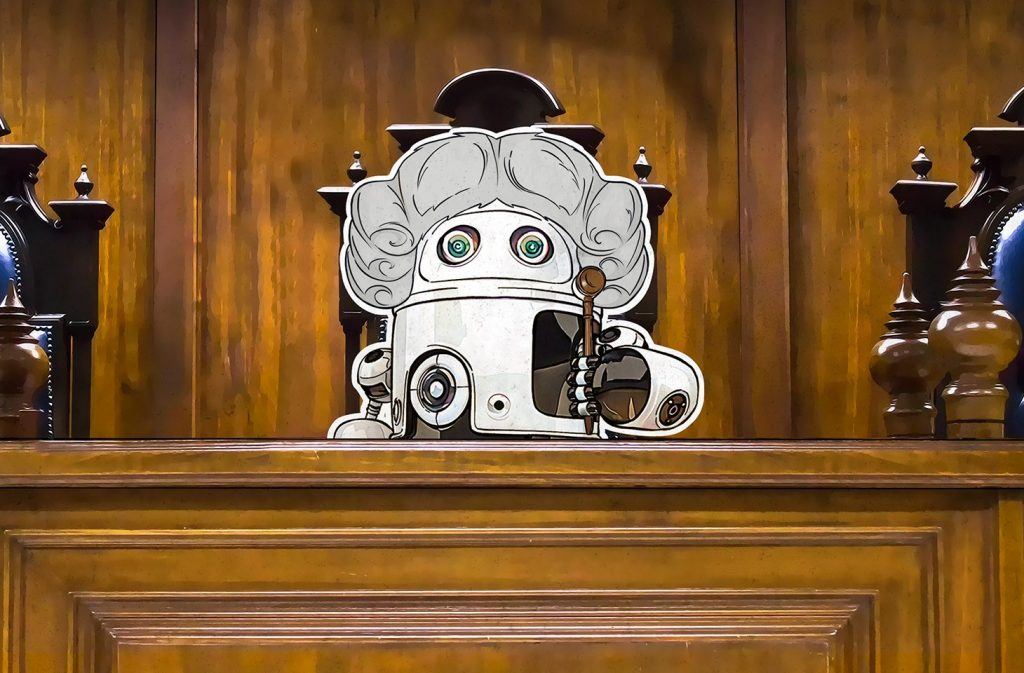

Как искусственный интеллект влияет на судьбы людей

Искусственный интеллект помогает судьям, полицейским и врачам, но чем он руководствуется при принятии решений?

Мы уже писали о том, какие серьезные ошибки может совершать искусственный интеллект в том виде, в котором он существует сейчас. И тем не менее, люди доверяют машине в очень важных вопросах. Уже сегодня самообучающиеся системы помогают принимать решения судьям и врачам и даже предсказывают еще не совершенные преступления. При этом пользователи таких систем далеко не всегда знают, на основе чего те делают свои выводы.

«Встать, суд загружается!»

В США искусственный интеллект помогает суду выносить приговоры, избирать меры пресечения и принимать решения о смягчении наказания. Если машина, изучив данные о подозреваемом, сочтет его склонным к рецидиву, ему могут дать реальный срок вместо условного или отказать в освобождении под залог.

Так, американца Эрика Лумиса (Eric Loomis) приговорили к шестилетнему заключению за управление автомобилем, пассажир которого обстрелял на ходу здание. Причиной тому — выводы системы COMPAS, оценивающей опасность человека для общества. Машина изучила историю взаимоотношений подсудимого с законом и его анкету — и признала Лумиса опасным. Защита пыталась оспорить это решение: принцип работы COMPAS не разглашается, а значит, нельзя говорить о справедливости выводов системы. Однако суд счел этот аргумент несущественным.

Электронные ясновидящие: ИИ предсказывает преступления

В некоторых регионах Китая пошли еще дальше — там находят при помощи искусственного интеллекта потенциальных преступников еще до того, как они нарушат закон. Камеры с системой распознавания лиц наблюдают за гражданами и сообщают правоохранительным органам, если в объектив попало что-то подозрительное. Например, если кто-то купил слишком много удобрений за раз — ведь их могут использовать для подготовки теракта. Человека, уличенного в сомнительном поведении, полиция имеет право арестовать или направить на принудительное перевоспитание.

Пытаются предсказывать преступления и в других странах. В некоторых регионах США и Великобритании полицейские используют компьютерную систему, которая определяет, где в ближайшее время может произойти инцидент. Она учитывает множество факторов: криминальную историю района, его социально-экономический статус и даже прогноз погоды. Удивительно, но с появлением «оракула» в тех районах Чикаго, где он работал, количество инцидентов со стрельбой уменьшилось примерно на треть.

Считайте на здоровье!

Новые технологии широко применяют и в медицине. Искусственные доктора консультируют пациентов, ставят диагнозы, анализируют результаты обследований и ассистируют хирургам при проведении операций.

Одна из самых известных самообучающихся систем в здравоохранении — IBM Watson Health. Врачи натаскивают искусственный интеллект диагностировать заболевания и назначать подходящую терапию. О Watson Health сказано много хорошего: так, в 2013 году вероятность того, что суперкомпьютер назначит пациенту оптимальное лечение, оценивали в 90%.

Однако летом 2018 года выяснилось, что система выдавала ошибочные рекомендации по борьбе с раком. В частности, онкобольному с обильным кровотечением Watson рекомендовал лекарство, которое могло привести к еще большей потере крови. К счастью, речь шла о тестовых материалах, а не о реальных пациентах.

Конечно, ошибки допускают и живые доктора, но с привлечением ИИ зона ответственности за принятые решения размывается. Рискнет ли врач ослушаться железного коллегу, который, по уверениям создателей, «изучил» сотни тысяч научных статей, книг и историй болезни? И если не рискнет — признает ли ошибку своей?

ИИ должен быть прозрачным

Одна из главных проблем с искусственным интеллектом, решающим судьбы людей, в том, что зачастую механизмы его работы непрозрачны, и в случае ошибки невозможно определить, что к ней привело и как избежать ее повторения в будущем. Разработчиков самообучающихся систем можно понять: кто захочет делиться своими ноу-хау с потенциальными конкурентами? Но стоит ли ставить коммерческую тайну во главу угла, если речь идет о жизни и судьбе людей?

Политики в разных странах пытаются урегулировать проблему непрозрачности принципов работы ИИ. В Европе, если решение автоматизированной системы затрагивает ваши интересы, вы имеете право узнать, на основе чего она сделала свои выводы. В Японии тоже собираются пойти этим путем, правда, соответствующий закон пока только рассматривается.

Встречаются сторонники прозрачности и среди разработчиков, хотя таких пока единицы. Например, компания CivicScape в 2017 году открыла исходный код своей системы предсказания преступлений. Однако это скорее исключение, чем правило.

Ожидать, что человечество откажется от помощи машин, не стоит. А до тех пор, пока нет уверенности, что искусственный интеллект принимает решения справедливо и точно, остается надеяться на законы и компетентность людей, создающих и использующих умные системы.

Источник: Лаборатория Касперского

12.02.2019